Command Palette

Search for a command to run...

WorldWarp:基于异步视频扩散的3D几何传播

WorldWarp:基于异步视频扩散的3D几何传播

Hanyang Kong Xingyi Yang Xiaoxu Zheng Xinchao Wang

Abstract

生成长时序、几何一致的视频面临一个根本性难题:一致性要求在像素空间中严格遵循三维几何结构,而当前最先进的生成模型在相机条件化的潜在空间中表现最为出色。这种空间上的脱节导致现有方法在处理遮挡区域和复杂相机运动轨迹时表现不佳。为弥合这一差距,我们提出 WorldWarp 框架,该框架将三维结构锚点与二维生成优化器相结合。为实现几何上的精确锚定,WorldWarp 采用基于高斯点阵(3DGS)的在线三维几何缓存机制,持续构建并更新三维结构。通过显式地将历史内容投影至新视角,该缓存充当结构骨架,确保每一帧新生成内容均遵循先前的几何约束。然而,静态投影不可避免地会在遮挡区域产生空洞与伪影。为此,我们引入一种面向“填充与修正”目标的时空扩散模型(Spatio-Temporal Diffusion, ST-Diff)。其核心创新在于设计了一种时空可变的噪声调度机制:空白区域接收完整的噪声以触发内容生成,而已有投影区域则仅接收部分噪声,从而实现精细化修正。通过在每一步动态更新三维缓存,WorldWarp 能够在视频片段之间保持长期一致性。最终,该方法在生成质量上达到当前最优水平——既由三维逻辑主导结构生成,又由扩散模型逻辑精细优化纹理细节。项目主页:https://hyokong.github.io/worldwarp-page/

一句话总结

新加坡国立大学与香港理工大学的研究人员提出 WorldWarp,这是一种新型视图合成框架,通过将 3D Gaussian Splatting (3DGS) 用于几何锚定与时空扩散(ST-Diff)模型相结合,实现从单张图像生成长时程连贯视频。其核心创新在于采用时空变化的噪声调度策略:对遮挡区域填充全噪声进行生成,同时对扭曲内容采用部分噪声进行细化,在先前方法失效的 200 帧序列中保持 3D 一致性。

核心贡献

- WorldWarp 解决了长时程视频生成中的根本矛盾:生成模型在隐空间运作,而几何一致性要求像素空间的 3D 约束,导致遮挡区域和复杂轨迹处理失败。该框架引入分块式架构,将在线 3D 几何缓存(通过 Gaussian Splatting 构建)与 2D 生成细化器耦合,维持结构锚定。

- 框架的核心创新是时空扩散(ST-Diff)模型,采用时空变化的噪声调度策略:对空白区域施加全噪声进行内容生成,对扭曲区域施加部分噪声进行细化,实现遮挡区域的有效"填充-修正",同时利用基于前向扭曲几何先验的双向注意力机制。

- WorldWarp 通过在每一步动态更新 3D 缓存,在具有挑战性的视图外推基准测试中实现了最先进的几何一致性和视觉保真度,避免了不可逆的误差传播,在有限起始图像的长序列生成中显著优于现有方法。

引言

新型视图合成技术可应用于虚拟现实和沉浸式远程呈现,但从有限图像实现交互式 3D 探索的关键在于生成远超输入相机位置的视图——即视图外推。现有方法存在显著局限:相机姿态编码难以处理分布外轨迹且缺乏 3D 场景理解,而显式 3D 空间先验在长序列生成中易受遮挡、几何失真和不可逆误差传播的影响。作者通过引入 WorldWarp 解决此问题,该框架采用基于分块的自回归流水线避免误差累积。其核心创新在于利用双向注意力机制的时空扩散模型,以未来相机位置的前向扭曲图像作为密集 2D 先验,同时结合在线 3D Gaussian Splatting 缓存,仅利用近期高保真输出动态优化几何结构。该方法确保了在先前工作失效的长距离相机路径上仍能保持几何一致性和视觉质量。

方法

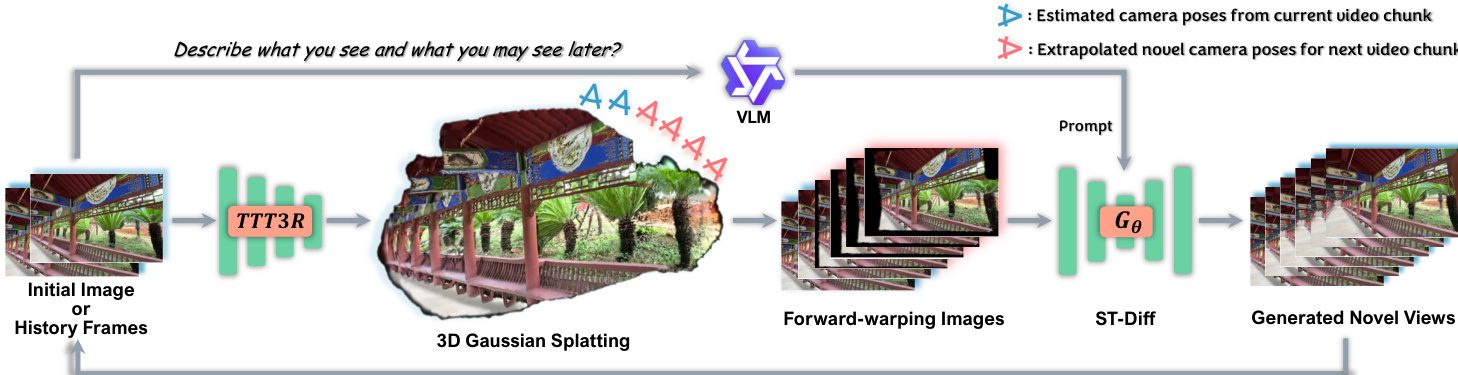

作者采用双组件架构实现长距离、几何一致的新型视图合成:在线 3D 几何缓存用于结构锚定,非因果时空扩散(ST-Diff)模型用于纹理细化和遮挡填充。框架以自回归方式运行,通过动态缓存更新迭代生成视频分块,维持全局 3D 一致性。

推理流水线的核心是在线 3D 几何缓存,其初始化源自起始图像或先前生成的分块。该缓存首先通过 TTT3R 估计相机姿态和初始点云,随后经过数百步优化构建 3D Gaussian Splatting (3DGS) 表示。此高保真 3DGS 模型作为结构支架,支持将当前历史准确前向扭曲至新视角。同时,视觉-语言模型(VLM)生成描述性文本提示以引导语义一致性,而下一帧分块的相机姿态则通过基于速度的线性平移和 SLERP 旋转插值得到。

参考自回归推理流水线:由 3DGS 缓存生成的前向扭曲图像及其对应的有效性掩码被编码至隐空间。ST-Diff 模型随后从空间变化的噪声水平启动反向扩散过程。对于每帧,噪声图基于隐空间掩码构建:有效(扭曲)区域以强度参数 τ 控制的降低噪声水平 σstart 初始化,保留几何结构;而遮挡(空白)区域以纯噪声(σfilled≈1.0)初始化,实现生成式修复。模型 Gθ 接收此混合噪声隐序列、VLM 提示及空间变化的时间嵌入,经 50 步去噪生成下一组新视角。新生成的分块成为下一次迭代的历史,确保长期连贯性。

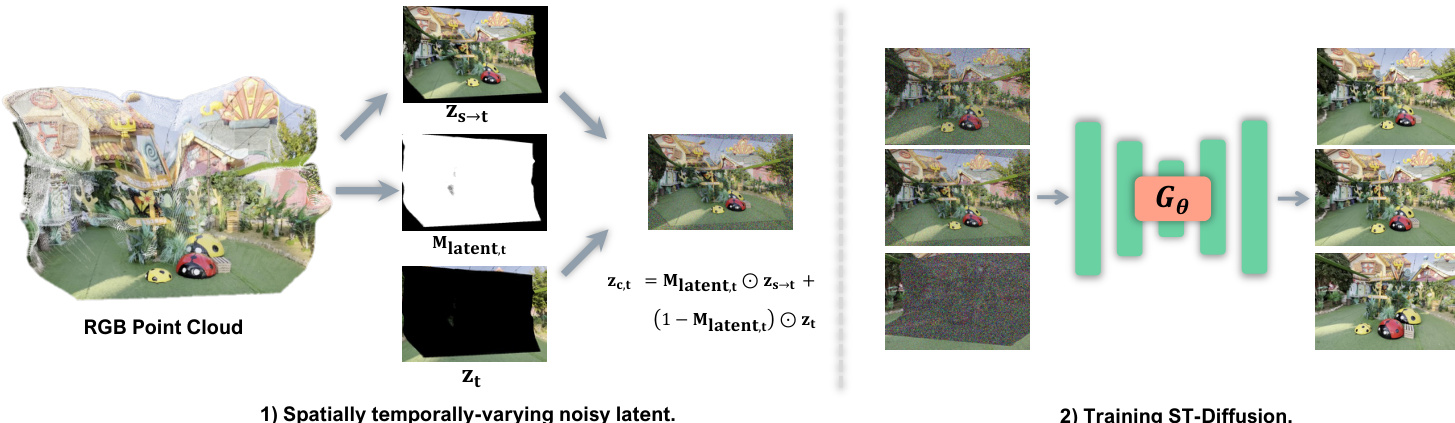

训练过程中,ST-Diff 模型以复合隐序列 Zc 为条件,该序列由扭曲先验和真实隐变量构建。复合序列通过结合 zs→t 的有效扭曲区域与 zt 的空白区域形成,使用下采样掩码 Mlatent,t:

zc,t=Mlatent,t⊙zs→t+(1−Mlatent,t)⊙zt该复合序列随后按时空变化的调度添加噪声:每帧 t 接收独立采样的噪声水平,且每帧内扭曲区域与填充区域分别接收噪声水平 σwarped,t 和 σfilled,t。生成的含噪隐序列输入 Gθ,该模型被训练以预测目标速度 ϵt−zt,迫使其学习从含噪复合序列回归真实隐序列的映射。此训练目标明确编码"填充-修正"行为:从纯噪声生成遮挡内容,同时从部分噪声状态细化扭曲内容。

实验

- 在 RealEstate10K 上实现最先进的长时程合成(第 200 帧),PSNR 17.13 和 LPIPS 0.352,超越 SEVA、VMem 和 DFoT,同时保持最低姿态误差(R_dist 0.697, T_dist 0.203),证明对相机漂移的卓越抑制能力。

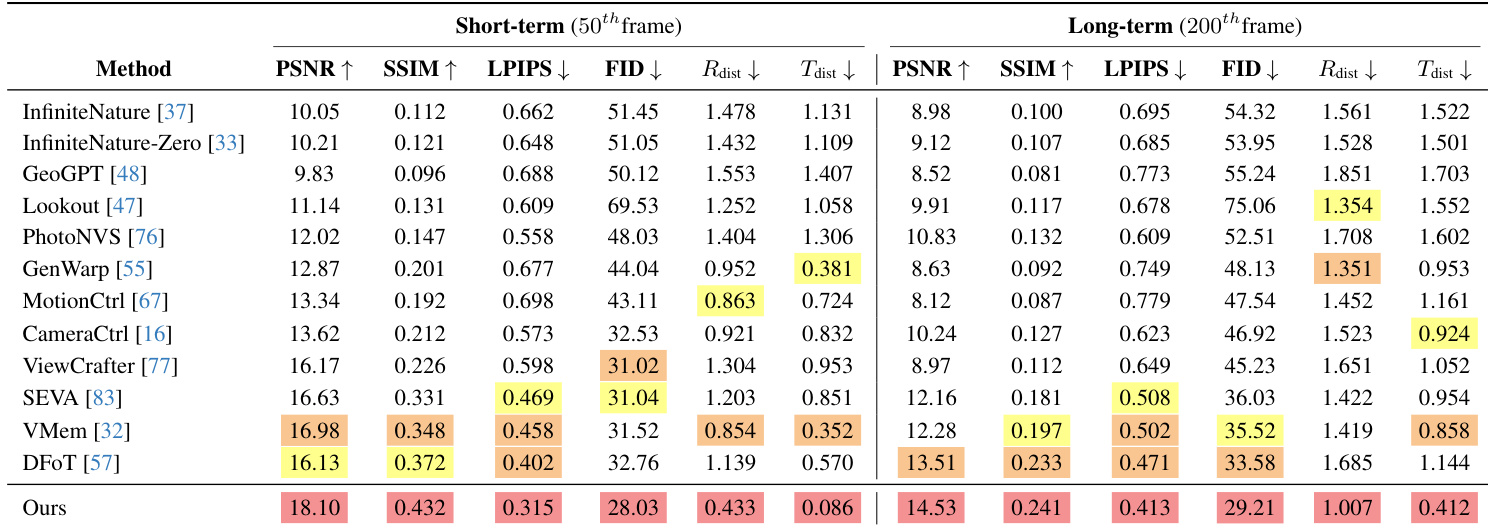

- 在轨迹复杂的 DL3DV 上,长时程合成中各项指标均领先(PSNR 14.53, R_dist 1.007),优于 DFoT(PSNR 13.51)和 GenWarp(R_dist 1.351),展现复杂场景的鲁棒性。

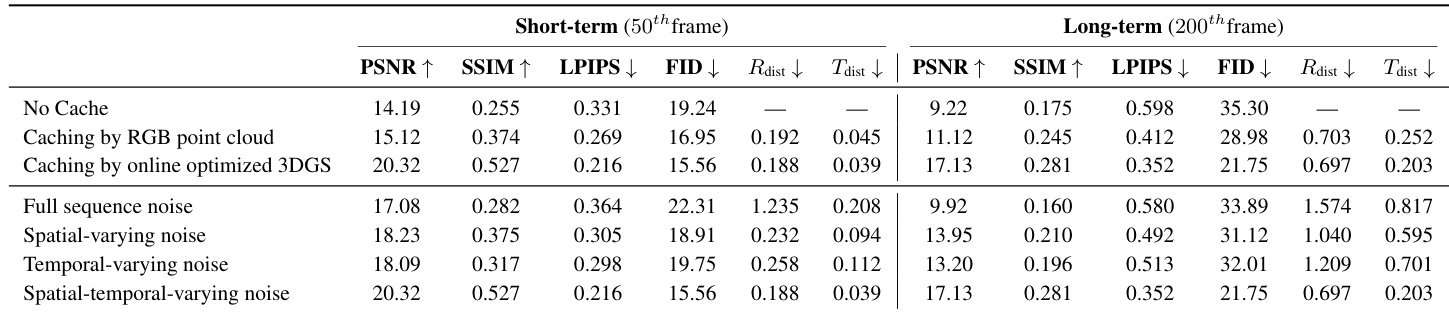

- 消融实验证实:基于 3DGS 的缓存对长距离保真度至关重要(PSNR 17.13 vs 无缓存 9.22);时空噪声扩散在生成质量(PSNR 17.13)与相机精度(R_dist 0.697)间取得最佳平衡,优于仅空间或仅时间变体。

作者在 RealEstate10K 数据集上评估模型变体,对比短时程(第 50 帧)与长时程(第 200 帧)视图合成的缓存策略及噪声扩散设计。结果表明:在线优化的 3DGS 缓存显著优于 RGB 点云缓存及无缓存方案,尤其在长时程生成中;完整时空噪声扩散设计在视觉质量与相机姿态精度间取得最佳平衡。

作者在 RealEstate10K 数据集上评估方法,短时程与长时程视图合成指标均表现最优。结果表明该方法在两种设置下均获得最高 PSNR 和最低 LPIPS,同时保持最精确的相机姿态估计(最小旋转与平移距离),尤其在长时程稳定性上显著超越基线。

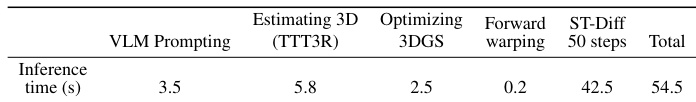

作者测量流水线各组件的推理延迟,显示 50 步去噪的 ST-Diff 占总耗时 42.5 秒,而 3D 相关操作(TTT3R、3DGS 优化、扭曲)合计仅 8.5 秒。结果证实几何约束的计算效率显著高于生成主干,后者占每视频分块 54.5 秒总推理时间的 78%。

作者在 RealEstate10K 数据集上评估方法,短时程与长时程视图合成指标均表现最优。该方法在保持最低 LPIPS、FID 和相机姿态误差(R_dist 和 T_dist)的同时,获得最高 PSNR 和 SSIM,尤其在长时程稳定性上大幅优于基线(多数基线显著退化)。这证明其时空噪声扩散策略在维持几何一致性和抑制累积相机漂移方面的有效性。