Command Palette

Search for a command to run...

DreamOmni3:基于涂鸦的编辑与生成

DreamOmni3:基于涂鸦的编辑与生成

Abstract

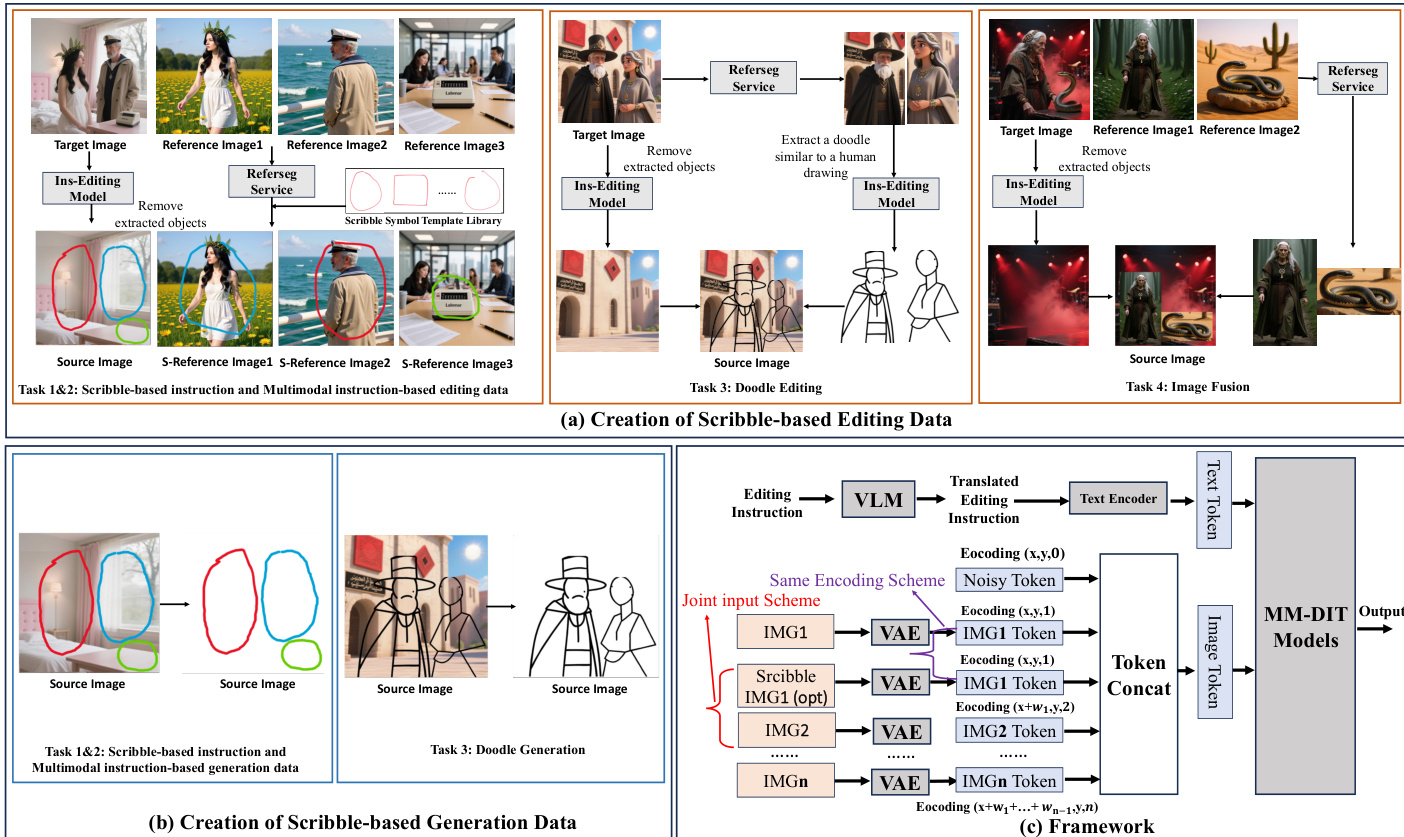

近年来,统一的生成与编辑模型在性能上取得了显著进展,展现出令人瞩目的能力。这些模型主要依赖文本提示来实现基于指令的图像生成与编辑,但语言描述往往难以准确表达用户意图的编辑位置以及精细的视觉细节。为此,我们提出两项新任务:基于涂鸦的图像编辑与生成,旨在通过结合用户提供的文本、图像及手绘草图,在图形用户界面(GUI)上实现更灵活的创作体验。为此,我们提出了 DreamOmni3,重点解决两大挑战:数据构建与框架设计。我们的数据合成流程包含两个部分:基于涂鸦的编辑与基于涂鸦的生成。在基于涂鸦的编辑任务中,我们定义了四项具体任务:基于涂鸦与文本指令的编辑、基于涂鸦与多模态指令的编辑、图像融合以及涂鸦式编辑。基于 DreamOmni2 数据集,我们提取可编辑区域,并叠加手绘的矩形、圆形、涂鸦或裁剪图像,构建训练数据。在基于涂鸦的生成任务中,我们定义了三项任务:基于涂鸦与文本指令的生成、基于涂鸦与多模态指令的生成,以及涂鸦生成,其数据构建流程与前述方法类似。在模型框架设计方面,我们摒弃了传统使用二值掩码(binary masks)的方式,因为其在涉及多个涂鸦、图像与指令的复杂编辑任务中表现受限。为此,我们提出一种联合输入机制:将原始图像与涂鸦图像同时输入模型,并通过不同颜色区分各类区域,从而简化处理流程并提升准确性。通过为两幅图像应用相同的索引编码与位置编码,模型能够精确识别涂鸦区域,同时保持编辑的高精度。最后,我们为上述任务建立了全面的基准评测体系,以推动后续研究的发展。实验结果表明,DreamOmni3 在各项任务中均表现出卓越性能。相关模型与代码将公开发布,供学术界与工业界使用。

一句话总结

香港中文大学、字节跳动和香港科技大学的作者提出 DreamOmni3,这是一种基于涂鸦的图像编辑与生成统一模型,通过颜色编码区域区分原图与涂鸦图,联合处理源图像与涂鸦输入,实现无需复杂二值掩码的精准区域定位,支持超越纯文本指令的灵活图形界面驱动创作,在复杂多涂鸦场景中优于先前方法,推动了交互式图像操作的发展。

主要贡献

- 我们引入了两项新任务——基于涂鸦的编辑与生成,通过在文本和图像输入之外加入手绘草图,扩展了统一生成与编辑模型,使图形界面下的用户交互更加直观、灵活且富有创意。

- 我们提出 DreamOmni3 的新型联合输入框架,利用颜色编码的涂鸦和共享位置编码,将原始图像与涂鸦图像同时输入模型,实现无需依赖复杂二值掩码的精确编辑区域定位。

- 我们构建了 DreamOmni3 基准数据集,基于真实世界图像数据,并建立全面的数据合成流程以支持多种基于涂鸦的任务,通过大量实验验证了其在编辑准确性和实际应用中的卓越性能。

引言

作者利用统一图像生成与编辑模型的最新进展,这些模型融合文本与图像输入以实现灵活的内容创作。然而,这些模型在精确、交互式编辑方面常面临挑战——尤其当用户需要修改难以用语言描述的特定区域、涉及模糊或相同对象,或需通过绘画实现创造性添加时。为解决此问题,作者提出 DreamOmni3 框架,通过引入基于涂鸦的编辑与生成能力,使用户能够通过手绘标注引导编辑与生成过程。该方法克服了基于掩码方法的局限性,后者依赖精确但往往繁琐的手动分割,且对不精确输入缺乏鲁棒性。DreamOmni3 引入新颖的数据流水线,为编辑与生成任务生成高质量、指令引导的涂鸦数据集,并提出联合输入架构,同时处理源图像与彩色涂鸦,通过共享位置编码保持空间对齐。该模型在统一框架内支持多模态输入(包括文本、图像和涂鸦),确保与现有架构兼容,并支持复杂、上下文感知的编辑。作者进一步基于真实世界数据建立了 DreamOmni3 基准,展示了模型在实际交互场景中的强大性能。

数据集

- 该数据集名为 DreamOmni3,基于 DreamOmni2 的多模态指令编辑与生成数据构建,扩展为包含涂鸦作为编辑与生成任务指令。

- 数据集包含两个主要部分:基于涂鸦的编辑数据集(70K 训练样本)和基于涂鸦的生成数据集(47K 训练样本),每部分均按不同任务类型组织。

- 编辑任务:

- 基于涂鸦与多模态指令的编辑包含 32K 样本,其中 Referseg 在参考图与目标图中定位对象,手动设计的涂鸦模板(方形与圆形)被粘贴至源图与参考图。

- 基于涂鸦与指令的编辑包含 14K 样本,由上述任务中移除参考图,保留涂鸦并添加对象描述至指令中。

- 图像融合包含 16K 样本,通过指令式编辑移除目标对象,使用 Referseg 从参考图中裁剪该对象,调整尺寸后粘贴至源图。

- 涂鸦编辑包含 8K 样本,其中 Referseg 识别对象,专用模型将其转换为抽象草图,避免使用 Canny 边缘检测(因用户输入不完美)。

- 生成任务:

- 基于涂鸦的多模态指令生成包含 29K 样本,涂鸦绘制在空白白色画布上,用于引导对象位置与属性生成。

- 基于涂鸦的指令生成包含 10K 样本,与上述类似,但无参考图,且指令中包含对象描述。

- 涂鸦生成包含 8K 样本,抽象草图绘制在白色画布上,引导模型生成对应对象与背景。

- 所有数据均采用联合输入方案处理,对源图与涂鸦图使用相同编码方法,确保像素对齐并兼容先前的 DreamOmni2 数据。

- 训练集使用所有可用样本进行训练,未明确划分验证集或测试集——评估通过新引入的 DreamOmni3 基准进行。

- 基准使用真实世界图像,涵盖全部七类任务,评估基于四项标准:指令准确性、视觉一致性(外观、对象、属性)、无严重伪影、与涂鸦区域对齐。

- 评估采用 VLM(如 GPT-Image-1)进行自动化评估,结果与人工评估高度一致,确保可靠性与现实相关性。

方法

作者采用统一框架实现基于涂鸦的图像编辑与生成,基于 DreamOmni2 架构并引入新颖的联合输入方案以处理手绘草图指令。整体框架如图所示,通过多模态模型(MM-DIT)整合文本与视觉输入,处理源图像、涂鸦图像与文本指令的组合。核心创新在于联合输入方案,将原始源图像与带涂鸦的修改版本同时输入模型。该方法避免了二值掩码的局限性——当存在多个涂鸦时,每个涂鸦需独立掩码并建立复杂的语言对应关系。相反,联合输入采用颜色编码涂鸦区分区域,使简单语言指令可通过图像索引与涂鸦颜色建立对应关系。

该框架通过一系列模块处理输入。文本编辑指令首先由视觉语言模型(VLM)转换为结构化格式,再传递至文本编码器生成文本标记。同时,源图像与涂鸦图像(如适用)通过变分自编码器(VAE)编码为图像标记。为确保原始图像与涂鸦图像之间的精确对齐,两者均采用相同的索引与位置编码方案,保留空间关系,使模型在非编辑区域保持像素级一致性。这些编码标记被拼接后输入 MM-DIT 模型,生成最终输出。联合输入方案选择性应用:在源图像含涂鸦的编辑任务中,同时输入原始与涂鸦图像;在生成任务或参考图像含涂鸦时,省略联合输入以避免不必要的计算开销。该选择性使用确保效率,同时保持模型处理复杂多涂鸦编辑场景的能力。

实验

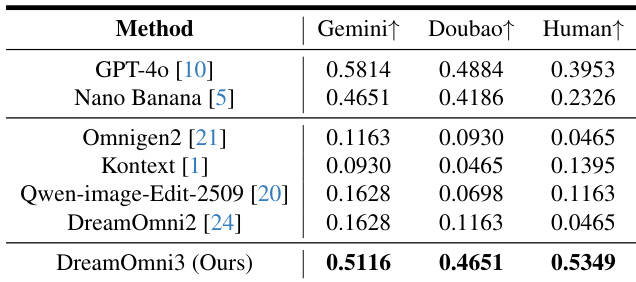

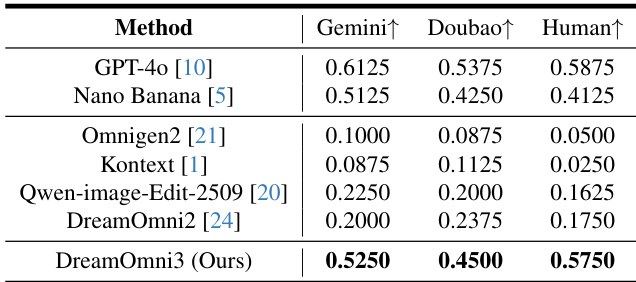

- 在 DreamOmni3 基准上评估基于涂鸦的编辑,使用 Gemini 2.5、Doubao 1.6 和人工评估(每案例 5 名评审员);DreamOmni3 在人工评估中取得最高通过率,优于开源模型,性能接近 GPT-4o 与 Nano Banana,但 GPT-4o 存在泛黄与像素错位问题,Nano Banana 出现复制粘贴效应与比例错误。

- 在基于涂鸦的生成任务中,DreamOmni3 超越开源模型(DreamOmni2、Qwen-image-edit-2509),性能与 GPT-4o 和 Nano Banana 相当,人工与 VLM 评估均证实其优势;商业模型即使在指令下仍生成不需要的涂鸦。

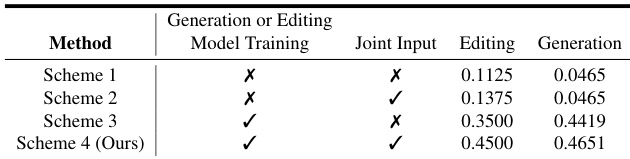

- 联合输入实验表明,使用自定义数据集训练并以源图像与涂鸦图像作为输入,显著提升编辑性能,尤其在像素级一致性方面;生成任务受益较弱,因对精确像素对齐需求较低。

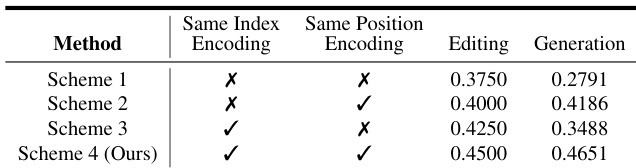

- 索引与位置编码实验显示,对源图像与涂鸦图像使用相同编码方案效果最佳,实现更好的像素级对齐并保持编辑准确性,同时兼容预训练能力。

作者对比了不同联合输入方案在基于涂鸦的编辑与生成中的表现,表明使用联合输入(源图像与涂鸦图像)训练显著提升性能。方案 4(联合输入 + 自定义数据集训练)在编辑(0.4500)与生成(0.4651)任务中均取得最高成功率,优于所有其他方案。

结果表明,DreamOmni3 在所有评估指标上均取得最高通过率,在基于涂鸦的编辑中超越开源模型及 GPT-4o、Nano Banana 等商业模型。作者使用 Gemini、Doubao 与人工评估者评估编辑成功率,DreamOmni3 在准确性和一致性方面均优于竞争方法。

结果表明,DreamOmni3 在所有评估指标上均取得最高通过率,在基于涂鸦的编辑中超越开源模型及 GPT-4o、Nano Banana 等商业模型。作者使用 Gemini、Doubao 与人工评估者评估编辑成功率,DreamOmni3 在准确性和一致性方面均优于竞争方法。

结果表明,对源图像与涂鸦图像使用相同的索引与位置编码,显著提升编辑与生成任务的性能。作者采用方案 4(联合输入 + 相同编码),取得最高得分,证明一致编码有助于提升像素级对齐并保留图像细节。